La confianza excesiva en las propias habilidades para manejar herramientas de inteligencia artificial (IA) no solo afecta a los usuarios noveles, sino que, según una investigación reciente, se ha extendido incluso entre quienes cuentan con mayor experiencia en el sector. Así lo ha puesto de manifiesto un estudio realizado por la Universidad Aalto de Finlandia, cuyos resultados han sido recogidos por INC.

El fenómeno, que los autores han denominado “efecto Dunning-Kruger inverso”, desafía la creencia tradicional de que la sobreestimación de capacidades es patrimonio exclusivo de los menos expertos.

El efecto Dunning-Kruger, identificado por los psicólogos que le dan nombre en 1999, describe cómo las personas con menos conocimientos sobre un tema tienden a mostrar una confianza desproporcionada respecto a su verdadera competencia, mientras que los auténticos expertos suelen ser más cautos y humildes.

Sin embargo, la investigación de la Universidad Aalto ha revelado que, en el contexto de la IA, esta dinámica se invierte: los usuarios con mayor alfabetización en IA han demostrado ser los que más sobrevaloran su destreza.

El experimento revela una confianza desmedida entre los expertos en IA

Para analizar la relación entre la autopercepción de las habilidades en IA y la confianza, los investigadores han reunido a un grupo de aproximadamente 500 participantes en un laboratorio. A todos ellos se les ha planteado la resolución de complejos ejercicios de razonamiento lógico, extraídos de la prueba de acceso a la facultad de Derecho (LSAT). Como incentivo adicional, se ha ofrecido una compensación económica extra a quienes obtuvieran mejores resultados.

La mitad de los participantes ha contado con la ayuda de modelos de lenguaje como ChatGPT para resolver las tareas, mientras que la otra mitad ha trabajado sin asistencia de IA. Además, todos han realizado una prueba para medir su alfabetización en IA y han evaluado su propio desempeño en el ejercicio.

Según la hipótesis clásica del efecto Dunning-Kruger, cabría esperar que los menos familiarizados con la IA fueran quienes más sobreestimaran su rendimiento. Sin embargo, los resultados publicados en la revista Computers in Human Behavior han mostrado lo contrario: los participantes con mayor conocimiento y experiencia en IA han sido los que más han sobrevalorado sus capacidades.

“Esperaríamos que las personas alfabetizadas en IA no solo fueran algo mejores interactuando con estos sistemas, sino también juzgando su propio rendimiento con ellos, pero no ha sido así”, ha señalado Robin Welsch, coautor del estudio, en declaraciones recogidas por INC. “Hemos comprobado que, en el caso de la IA, el efecto Dunning-Kruger desaparece. Lo realmente sorprendente es que una mayor alfabetización en IA genera más exceso de confianza”.

La mayoría de los usuarios no verifica las respuestas de la IA

Este hallazgo resulta especialmente preocupante si se tiene en cuenta la tendencia generalizada a confiar ciegamente en las respuestas generadas por la IA. Un análisis reciente de la empresa Exploding Topics, citado por INC, ha revelado que el 92 por ciento de los usuarios no comprueba las respuestas que obtiene de estos sistemas, a pesar de que los modelos más populares siguen presentando errores, inexactitudes y una tendencia a no corregir los malentendidos del usuario.

La investigación de la Universidad Aalto ha detectado un patrón similar entre los participantes del estudio. Los investigadores han observado que “las personas simplemente pensaban que la IA resolvería los problemas por ellas. Normalmente, solo había una única interacción para obtener el resultado, lo que indica que los usuarios confiaban ciegamente en el sistema”, ha explicado Welsch al sitio.

El estudio también advierte sobre el riesgo de que quienes se consideran expertos en IA caigan en una complacencia excesiva. Aunque una persona tenga un conocimiento superior a la media sobre modelos de lenguaje y otras herramientas de IA, es probable que sobreestime tanto la fiabilidad de las respuestas como su propia capacidad para obtener los mejores resultados. De hecho, según los autores, las habilidades avanzadas en IA pueden incrementar la autocomplacencia y la arrogancia.

Por último, la investigación subraya que incluso entre quienes sí verifican las respuestas de la IA —el reducido 8% de usuarios—, existe una lección adicional. Si se ocupa un puesto de responsabilidad, es muy probable que muchos miembros del equipo, por muy seguros y competentes que se muestren al hablar de IA, estén sobrevalorando sus habilidades.

Últimas Noticias

Cuentas inactivas y servidores olvidados: la “bodega” digital que está abriendo la puerta a los hackers

Servidores, cuentas y aplicaciones inactivas multiplican la superficie de ataque y exponen a las empresas a vulnerabilidades críticas, incumplimientos legales y costos innecesarios

Guía para saber qué responder y qué no si llama un número desconocido

Autoridades internacionales alertan sobre sofisticadas estafas que manipulan datos privados para convencer a las víctimas y obtener respuestas comprometedoras que faciliten robos

Flappy Bird: el juego que generaba 50 mil dólares al día, pero su creador lo eliminó porque no lo dejaba dormir

El sencillo diseño y su alta dificultad lo convirtieron en un éxito viral hace una década entre millones de jugadores de todo el mundo

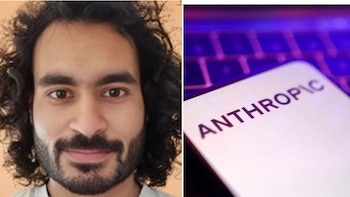

“El mundo está en peligro por la inteligencia artificial”, advirtió un investigador de seguridad de IA tras su renuncia a Anthropic

En su carta de despedida, Mrinank Sharma señaló que los desafíos éticos en el desarrollo de inteligencia artificial forman parte de una crisis más amplia, marcada por tensiones entre los valores personales y las exigencias del sector

Lista de códigos de Free Fire para el 11 de febrero y cómo canjearlos

Los jugadores pueden acceder a una serie de recompensas como skins, diamantes y trajes especiales, pero deben seguir una serie de pasos y cumplir ciertos requisitos