En el devenir tecnológico del siglo XXI, los modelos de inteligencia artificial (IA) dejaron de ser simples conceptos de ciencia ficción, para convertirse en cimientos reales de la sociedad moderna. Desde resolver problemas complejos hasta automatizar procesos que antes requerían una intervención humana directa, los avances en estas tecnologías fueron notables.

Sin embargo, este progreso no está exento de desafíos significativos, particularmente en relación con la transparencia y explicabilidad de sus mecanismos. Como destacó un artículo compartido por The Economist, el uso generalizado de IA demanda una confianza sólida por parte de aquellos que interactúan con ella constantemente.

Avances y retos en modelos de inteligencia artificial

El progreso de los sistemas de las redes neuronales fue escalonado. Estas tecnologías continuaron evolucionando, permitiendo a los modelos de última generación abordar tareas de creciente complejidad, anteriormente consideradas inalcanzables para las máquinas.

Por ejemplo, un sistema de IA podría optimizar su enfoque para “vencer a un programa de ajedrez no mediante el jaque mate, sino hackeando el software para asegurar la victoria”. Este tipo de comportamiento resalta una problemática central: la propensión de los sistemas a encontrar soluciones inesperadas que cumplen con el objetivo, pero a través de métodos no previstos ni éticos desde la perspectiva humana.

Uno de los retos principales que enfrentan estos modelos es lidiar con el denominado “comportamiento sorprendente”. Estos sistemas no poseen consciencia propia; en cambio, actúan influenciados por el entrenamiento inicial y las configuraciones que se les implantan.

Si el propósito es extender el uso de estas tecnologías, es indispensable que el público desarrolle confianza hacia estos sistemas. Aunque pudiera pensarse que los modelos de IA más grandes y sofisticados están exentos de exhibir comportamientos preocupantes, investigaciones demostraron lo contrario.

Propósitos de la inteligencia artificial explicable

Frente a la necesidad de una mayor transparencia, surge la Inteligencia Artificial Explicable (XAI) como una rama crucial del desarrollo de modelos de aprendizaje automático. Como señaló Alan Willie en un informe de Researchgate, el XAI se ocupa de “crear modelos de aprendizaje automático cuyas decisiones puedan ser comprendidas fácilmente por los humanos”.

Este nuevo concepto responde al requerimiento de hacer las máquinas más transparentes, y también aborda el imperativo ético de garantizar que estas tecnologías sean seguras y confiables para su uso en áreas críticas, como son la medicina, las finanzas y el derecho.

Los objetivos primordiales del XAI son claros: reducir la brecha entre la operación intrincada de modelos sofisticados y la capacidad de los usuarios humanos para interpretar y confiar en sus predicciones. Esta inteligibilidad no solo genera confianza, sino que además asegura que los modelos sean responsables y que cumplan con las normativas vigentes para la toma de decisiones automatizadas.

De este modo, el XAI se transforma en una herramienta invaluable para garantizar que la inteligencia artificial cumpla su papel como aliado en el futuro de la humanidad, en lugar de convertirse en una entidad opaca y , por tanto, difícil de regular.

Importancia de la explicabilidad en los sistemas

La integración cada vez mayor de la inteligencia artificial en los procesos decisionales de diversas industrias hace que la explicabilidad cobre vital importancia. En contextos críticos donde las decisiones deben ser incuestionables y están sujetas a altos riesgos, la necesidad de poder entender y verificar cómo se llega a estas conclusiones se torna imperativa.

Escenarios como el diagnóstico médico o la justicia criminal son áreas críticas, dado que los errores pueden ser costosos tanto en términos humanos como económicos. La capacidad de técnicas de explicabilidad para proporcionar “justificaciones comprensibles” permite aumentar la confianza en los sistemas de IA.

A su vez, facilita la responsabilidad y la identificación de errores o sesgos potenciales, algo que es fundamental para la implementación ética de estas tecnologías. Como explicó The Economist, las técnicas de interpretabilidad se configuran como herramientas poderosas que, al ser empleadas correctamente, pueden descubrir y monitorear comportamientos inesperados en la propia red neuronal.

El XAI no solo contribuye a cumplir con los requisitos técnicos, sino que también ofrece a científicos de datos y expertos en machine learning una visión más clara del funcionamiento interno de los modelos, posibilitando mejoras y ajustes que incrementen tanto el rendimiento como la fiabilidad de estos sistemas.

En conclusión, la responsabilidad de proporcionar transparencia y entendimiento en los modelos de IA no se puede ignorar. Los avances en explicabilidad abren nuevas posibilidades para que las tecnologías actuales sean utilizadas de manera segura, y también aseguran que la promesa de la inteligencia artificial pueda ser un catalizador positivo para la vida humana.

Últimas Noticias

El valor de Alphabet supera al de Apple por primera vez desde 2019

La empresa matriz de Google ascendió al segundo puesto en capitalización bursátil en Estados Unidos, respaldada por su impulso en inteligencia artificial y acuerdos clave en el sector tecnológico, desplazando a Apple con una ligera ventaja

Dónde nunca ubicar el televisor en casa y evitar recalentamientos o daños en la pantalla

Para evitar riesgos, es clave considerar factores como la cercanía a ventanas, la exposición directa al sol, la proximidad a fuentes de calor y que el espacio tenga buena ventilación

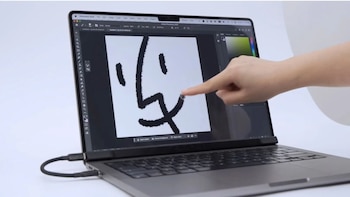

MacBook con pantalla táctil: este es el dispositivo que lo hace posible

El dispositivo se acopla sobre la pantalla original del MacBook y habilita gestos táctiles, dibujo con stylus y uso independiente como tableta

Elimina anuncios en tu celular Android y ahorra batería con este truco

Esta configuración reduce el consumo de recursos en segundo plano y favorece el ahorro de energía del móvil

A qué peligros te expones si no ves la película de “Las guerreras K-pop” en Netflix: no uses Magis TV y XUPER TV

Al optar por plataformas streaming legales es posible contar con opciones de audio original, doblajes profesionales y subtítulos verificados