El avance de la inteligencia artificial ha impulsado la aparición de un fenómeno que preocupa a la industria tecnológica: los ataques de inyección, una amenaza sofisticada y difícil de detectar en la verificación de identidad digital.

De acuerdo con Jumio, compañía de autenticación biométrica y análisis de datos, este tipo de fraude ha registrado un aumento global sostenido, especialmente en América Latina.

Cómo es la nueva manera de hacer fraude con la IA

Los ataques de inyección se diferencian de las tácticas tradicionales de suplantación de identidad porque introducen datos sintéticos directamente en los sistemas, sin recurrir a cámaras físicas o trucos visuales convencionales.

A través del uso de emuladores y software especializado, los estafadores inyectan videos generados por inteligencia artificial o señales biométricas sintéticas, logrando evadir controles y comprometer plataformas financieras.

“Los ataques de inyección son cada vez más difíciles de detectar, ponen a prueba la tecnología, elevan el nivel de riesgo en cuanto a fraude y desafían la confianza en los sistemas digitales”, explicó al equipo de Infobae, Samer Atassi, vicepresidente para América Latina de Jumio.

Atassi detalló que la facilidad de acceso a herramientas de IA ha propiciado un auge en el uso de identidades ficticias y videos manipulados: “La inteligencia artificial está al alcance de cualquier persona. Eso es positivo para la creatividad y la innovación, pero también tiene un lado negativo porque facilita la creación de identidades falsas”.

En este contexto, situaciones antes consideradas posibles solo en películas de ciencia ficción ya se observan en procesos cotidianos de apertura de cuentas o verificación en bancos, fintechs y otras plataformas digitales.

Cómo funciona la inyección de video con IA

Una de las particularidades de los ataques de inyección radica en la capacidad de manipular el canal de entrada sin necesidad de presentar una imagen o video ante la cámara física.

“El estafador, en lugar de abrir la cámara de su dispositivo, abre una cámara virtual e inyecta un video de una identidad generada previamente con IA. Con esto, puede suplantar la biometría del usuario, abrir cuentas en bancos o fintechs y gestionar operaciones bajo una identidad robada”, explicó Atassi.

Como parte del proceso, detalles como el movimiento de ojos, labios o gestos faciales resultan casi imposibles de distinguir para los sistemas tradicionales, volviendo a estos fraudes especialmente riesgosos.

Según datos recientes, Jumio identificó un incremento del 88% en los intentos de ataques de inyección en el último año. El reporte de la compañía asocia este crecimiento con la proliferación de tecnologías deepfake y la disponibilidad de herramientas de manipulación en la dark web, lo que ha facilitado intentos de fraude cada vez más complejos en la región.

Los riesgos derivados van más allá de la evasión de controles regulatorios o la suplantación de identidad. Estos ataques pueden comprometer la integridad de los procesos digitales, derivar en fraudes financieros y erosionar la confianza de usuarios y aliados estratégicos en la seguridad de las plataformas, según advierte la compañía.

El uso de tecnologías de liveness o prueba de vida ha dejado de ser un valor añadido y se ha convertido en un componente esencial para identificar ataques de inyección.

Las tendencias observadas en los ataques de inyección muestran que la ciberseguridad enfrenta desafíos cada vez más sofisticados, impulsados por la facilidad de acceso a herramientas de inteligencia artificial y el intercambio global de técnicas de fraude.

La adaptación constante de los sistemas, la capacitación tecnológica y la vigilancia ante nuevas vulnerabilidades se consolidan como aspectos clave para reducir los riesgos y preservar la confianza en los entornos digitales.

La cooperación entre empresas, instituciones y usuarios resulta indispensable para mitigar el impacto de estos delitos y fortalecer los mecanismos de protección en el ecosistema digital.

Últimas Noticias

Cómo funciona ‘Picks’, la función experimental de Instagram inspirada en apps de citas

Un usuario podría seleccionar intereses como películas, música, libros, videojuegos o series, y recibir notificaciones cuando existan coincidencias con sus contactos

Sam Altman afirma que la humanidad seguirá viéndose como protagonista pese al avance de la IA

El creador de ChatGPT reconoció que los avances tecnológicos han sido capaces de modificar paradigmas, pero no de anular la tendencia de la humanidad a situarse en el centro

OpenAI no descarta anuncios en ChatGPT y revisa esquemas de monetización

Nick Turley, responsable de ChatGPT, señaló que la empresa mantiene “la mente abierta” respecto a la inclusión de publicidad

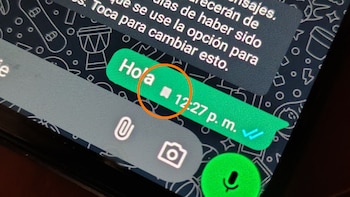

Banderita de WhatsApp: qué significa este ícono y cómo usarlo en los chats

La herramienta ayuda a preservar datos importantes sin sacrificar la privacidad ni la limpieza del chat

Qué significa recibir un código de verificación de WhatsApp sin solicitarlo

Ante la llegada de un SMS inesperado, activistas de la ciberseguridad alertan sobre técnicas de secuestro de cuenta, SIM swap y suplantaciones que amenazan la privacidad y el control de tus mensajes privados